爬虫宠物入门教程图解大全

- 教程大全

- 2025-08-25

- 2

《爬虫宠物入门教程图解大全:轻松掌握网络数据采集技巧》

随着互联网的快速发展,数据已经成为现代社会的重要资源,爬虫技术作为网络数据采集的重要手段,越来越受到人们的关注,对于初学者来说,掌握爬虫技术可以让我们更好地利用网络资源,提升自己的技能,本文将为您带来一份爬虫宠物入门教程图解大全,帮助您轻松入门。

什么是爬虫? 爬虫(Spider)是一种模拟搜索引擎工作的程序,它可以在互联网上自动抓取网页信息,并存储到本地数据库中,通过爬虫技术,我们可以获取到大量的网络数据,为我们的研究、学习和工作提供便利。

爬虫宠物入门教程

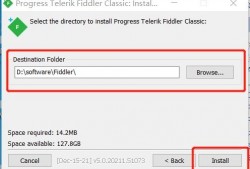

环境搭建 我们需要搭建一个爬虫开发环境,以下是一个简单的环境搭建步骤:

(1)安装Python:访问Python官网(https://www.python.org/)下载并安装Python。

(2)安装第三方库:在命令行中输入以下命令,安装常用的爬虫库:

pip install requests beautifulsoup4 lxml爬虫基本原理 爬虫的基本原理是通过发送HTTP请求获取网页内容,然后解析网页内容,提取所需信息,以下是一个简单的爬虫示例:

import requests

# 发送HTTP请求

url = 'http://www.example.com'

response = requests.get(url)

# 解析网页内容

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'lxml')

# 提取信息= soup.find('title').text

print(title) 爬虫宠物实战 以下是一个简单的爬虫宠物实战案例,我们将从某个网站爬取宠物信息:

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求

url = 'http://www.example.com/pets'

response = requests.get(url)

# 解析网页内容

soup = BeautifulSoup(response.text, 'lxml')

# 提取宠物信息

pets = soup.find_all('div', class_='pet')

for pet in pets:

name = pet.find('h2').text

age = pet.find('span', class_='age').text

print(f'宠物名称:{name},年龄:{age}') 爬虫宠物进阶 在实际应用中,我们可能需要处理以下问题:

(1)翻页处理:有些网站支持翻页功能,我们可以通过循环请求不同页码的URL来获取更多数据。

(2)反爬虫策略:一些网站为了防止爬虫,会采取反爬虫策略,如IP封禁、验证码等,针对这些情况,我们可以使用代理IP、验证码识别等技术来应对。

(3)分布式爬虫:对于需要爬取大量数据的场景,我们可以使用分布式爬虫技术,提高爬取效率。

本文为您介绍了一份爬虫宠物入门教程图解大全,从环境搭建、基本原理到实战案例,帮助您轻松入门爬虫技术,希望您能通过学习,掌握网络数据采集技巧,为今后的学习和工作打下坚实基础。

上一篇

灯控台 入门教程图解

下一篇

如何自学绘画入门教程图片