爬虫技术新手入门教程

- 教程大全

- 2025-09-03

- 1

轻松掌握网络数据的采集与处理

随着互联网的快速发展,网络数据已经成为各行各业的重要资源,爬虫技术作为一种高效的数据采集手段,被广泛应用于信息检索、数据挖掘、市场调研等领域,对于新手来说,掌握爬虫技术无疑是一项非常有价值的技能,本文将为您提供一个全面的爬虫技术新手入门教程,帮助您轻松掌握网络数据的采集与处理。

爬虫技术概述

爬虫的定义

爬虫(Spider)是一种模拟人类浏览器行为的程序,它可以在互联网上自动抓取网页内容,并将其保存到本地或数据库中,爬虫技术是网络数据采集的基础,是实现数据挖掘、信息检索等应用的关键。

爬虫的分类

根据爬虫的工作方式,可以分为以下几类:

(1)通用爬虫:以搜索引擎为代表的爬虫,如百度、谷歌等,它们会遍历互联网上的网页,抓取信息。

(2)聚焦爬虫:针对特定领域或网站的爬虫,如新闻网站、电商平台等,它们只抓取特定领域的网页。

(3)深度爬虫:通过分析网页内容,挖掘更深层次的信息,如评论、回复等。

爬虫技术新手入门教程

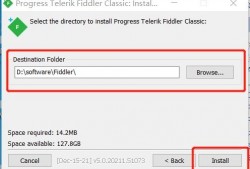

环境搭建

(1)安装Python:爬虫技术主要使用Python语言,因此首先需要安装Python环境。

(2)安装第三方库:常用的爬虫库有requests、BeautifulSoup、Scrapy等,可以通过pip命令安装:

pip install requests

pip install beautifulsoup4

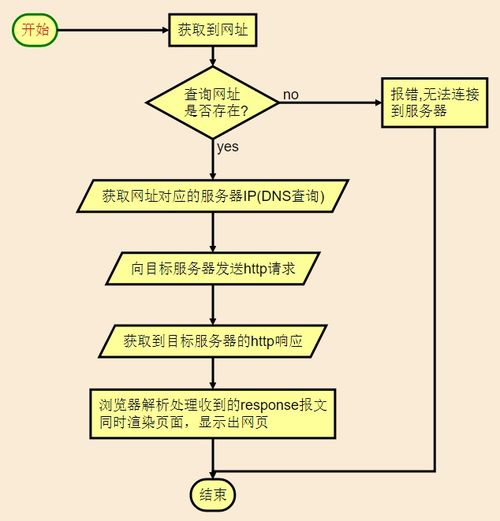

pip install scrapy网络爬虫基本原理

(1)发送请求:使用requests库发送HTTP请求,获取网页内容。

(2)解析网页:使用BeautifulSoup或lxml库解析网页内容,提取所需数据。

(3)数据存储:将提取的数据保存到本地文件或数据库中。

爬虫实战案例

以下是一个简单的爬虫案例,用于抓取某个网站的新闻列表:

import requests

from bs4 import BeautifulSoup

# 发送请求

url = 'http://www.example.com/news'

response = requests.get(url)

# 解析网页

soup = BeautifulSoup(response.text, 'html.parser')

news_list = soup.find_all('div', class_='news-item')

# 提取数据

for news in news_list:= news.find('h2').text

author = news.find('span', class_='author').text

print(f'标题:{title}\n作者:{author}\n')

# 数据存储(此处省略) 遵守网站规则

在进行爬虫时,一定要遵守目标网站的robots.txt规则,尊重网站的版权和隐私政策,避免对网站造成过大压力,合理设置爬虫频率。

爬虫技术是网络数据采集的重要手段,掌握爬虫技术可以帮助您快速获取所需数据,本文为您提供了一个爬虫技术新手入门教程,希望对您有所帮助,在实际应用中,您可以根据需求不断优化和扩展爬虫功能,提高数据采集效率。

上一篇

游戏精算师入门教程

下一篇

纸笔画画入门教程简单